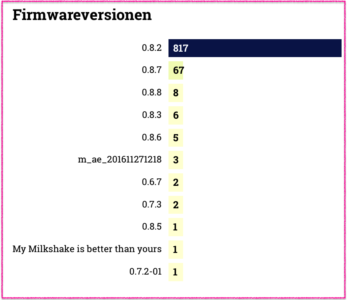

Unser Göttinger Freifunk-Netz verwendet (Stand Oktober 2018, mit sehr wenigen Ausnahmen) zwei Firmware-Versionen:

- Stable: 0.8.7 (Gluon 2016.2.3)

- Beta: 0.9.2 (Gluon-v2017.1.4)

Die Betaversion sollte eigentlich auch mal zur stable werden, aber das Projekt haben wir einschlafen lassen. Wir sehen sie daher nur auf Nodes, die von der stable Version nicht unterstützt werden.

Durch unsere Faulheit haben wir zwar ein sehr stabiles Netz, das wenig durch mit Technik spielende Administratoren belästigt wird, aber die Bitten um neuere Firmware zwecks Einsatz neuerer Hardware werden häufiger.

Das Netz produziert (leider) immer noch immer mehr Traffic, obwohl die Anzahl der Nodes ziemlich stabil um die 800 schwankt. Damit sind wir gerade noch in der Lage weiterzumachen, ohne den großen Aufwand einer Aufteilung des Netzes durchführen zu müssen.

Das Wachstum des Netzes über die problematische Grenze hinaus haben wir halbwegs erfolgreich gebremst, in dem wir z.B. Werbemaßnahmen eingestellt haben und befreundete Freifunk-Projekte im Landkreis ermuntert haben, anstatt das Göttinger Netz immer größer zu machen, eigenständige Netze aufzubauen. Die besten Beispiele sind die großen Projekte in Hann-Münden und Einbeck. Von der Anzahl der Nodes her wäre das ganz offensichtlich auch in Osterode und Duderstadt denkbar.

Und seit Abschaffung der Störerhaftung beraten wir Interessenten, die dafür in Frage kommen, immer in die Richtung, doch einfach ein offenes WLAN bereitzustellen, und das gerne auch “Freifunk” zu nennen.

Dennoch ist unser letztes Firmware-Update lange her und die Router-Hersteller nehmen bewährte Hardware vom Markt um immer neue hinterherzuschieben. Die Schornsteine müssen rauchen. Also dann…

Das Gluon-Team hat Updates herausgebracht, mit 29 (!) neuen Hardware Plattformen. Das Update erfolgt in zwei Schritten, weil die TP-Link CPE 210/510 für den Sprung auf die aktuellste Version eine Zwischenversion benötigen.

In den nächsten Wochen werdet Ihr daher zwei Upgrades erleben:

- Auf 0.9.3 (Gluon 2017.1.8) (wegen TP-Link CPE 210/510)

- Auf 0.10.0 (Gluon 2018.1.1)

Wer einen VPN-Beschleuniger einsetzt, lese bitte baldmöglichst:

https://gluon.readthedocs.io/en/v2018.1.x/releases/v2017.1.htm

Die allermeisten von Euch haben ihre Freifunk-Router auf “stable” und “autoupdate” stehen und müssen daher nichts machen. Alle anderen sollten die neuen Firmwareversionen von Hand einspielen (oder die Router umstellen).

Wir haben Euch die neuen Plattformen aus den Release-Notes zusammengeschrieben. Neben sehr vielen, teilweise sicherheitsrelevanten Bugfixes wird wie gesagt, ganz viel neue Hardware unterstützt.

Drückt uns allen die Daumen

Eure Göttinger Freifunker

(Gluon 2016.2.6)

ar71xx-generic

(Gluon 2017.1)

ar71xx-generic

- TP-Link

- RE450

- WBS210 v1.20

- WBS510 v1.20

- Ubiquiti

- AirGateway LR

- AirGateway PRO

- Rocket M2/M5 Ti

- UniFi AP LR

ar71xx-tiny

- TP-Link

- TL-WA730RE v1

- TL-WA7210N v2

x86-generic

The x86-kvm and x86-xen_domu targets have been removed; the x86-generic images now support these usecases as well, so no separate targets are needed anymore.

x86-geode

The new x86-geode target for hardware based on Geode CPUs has been added.

(Gluon 2017.1.4)

ar71xx-generic

(Gluon 2017.1.5)

ar71xx-generic

ramips-mt7621

- Ubiquiti EdgeRouter-X

- Ubiquiti EdgeRouter-X SFP

(Gluon 2017.1.8)

ar71xx-generic

- GL.iNet GL-AR750

- TP-Link Archer C7 v4

- Ubiquiti UniFi AC Mesh

ar71xx-tiny

(Gluon 2018.1)

ar71xx-generic

- ALFA NETWORK

- AVM

- OpenMesh

- A40

- A60

- OM2P v4

- OM2P-HS v4

- TP-Link

- Archer C59 v1 [2]

- CPE210 v2

ar71xx-nand

ar71xx-tiny

ipq806x

ramips-mt7620

- GL Innovations

- GL-MT300A

- GL-MT300N

- GL-MT750

ramips-mt7628

ramips-rt305x

- A5

- D-Link

- DIR615 (D1, D2, D3, D4, H1)

- VoCore

sunxi

Wir starten morgen ein Update der Firmware im Göttinger Freifunk-Netz.

Wir starten morgen ein Update der Firmware im Göttinger Freifunk-Netz.